Schnell mal die KI nutzen, um aktuelle Informationen zu finden, sich einen Text zusammenfassen oder eine Einleitung schreiben zu lassen oder nach Literatur zu recherchieren? Das kann gut gehen – muss es aber nicht: Es gibt eine Reihe von Risiken, die es beim Gebrauch von KI als Hilfsmittel im wissenschaftlichen Arbeiten zu beachten gilt, insbesondere für KI-Anwendungen in Form von Sprachmodellen (LLM: Large Language Models), wie z. B. ChatGPT, Mistral oder Llama.

Eines der größten dieser Risiken sind sogenannte Halluzinationen. Hierbei werden von der KI frei erfundene Inhalte so präsentiert, als wären sie faktisch richtig und glaubwürdig. Dies passiert häufig bei der Zusammenfassung von Texten, die halluzinierte Aussagen ohne Bezug zum Originaltext beinhalten. Auch bei der Quellenrecherche ist Vorsicht geboten, da teilweise wissenschaftlichen Publikationen mit Autor und Titel angegeben werden, die gar nicht existieren.

Info: Was sind Halluzinationen?

Halluzinationen bleiben ein Problem bei der Verwendung von großen Sprachmodellen (LLMs). Es handelt sich um KI-generierte Inhalte, die zwar plausibel erscheinen, jedoch von der KI frei erfunden werden. Das kann bei Textzusammenfassungen passieren, indem KI-Programme bei der Abfrage von Informationen Antworten generieren, die nicht den Informationen des Originaltexts entsprechen. Bei Falschinformationen, die zwar faktisch richtig sind, jedoch nicht im Quellentext vorkommen, spricht man von mangelnder Übereinstimmung (faithfulness) (Sieber 2024).

Halluzinationen können außerdem mangelnde faktische Richtigkeit (factfulness) aufweisen, z.B. Quellenangaben, in denen Autor:innen und Einrichtungen, die zu einem Thema arbeiten, mit frei erfundenen Titeln und Jahreszahlen zusammengebracht werden, oder auch faktisch falsche Antworten auf simple Wissensfragen (Sieber 2024).

Wie kann ich das Risiko verringern?

Das Vorgehen dazu ist zweischrittig: Zum einen kommst Du nicht umhin, alle angegeben Fakten und Aussagen in den Originalquellen zu überprüfen – und sie selbst zu lesen!

Zum anderen kannst Du beim Nutzen von KI einige Hinweise berücksichtigen. Das Auftreten von Halluzinationen kann auf verschiedene Weisen verringert werden:

„Chain of thought“-Abfrage

Besonders hilfreich ist es, den Denkprozess der KI zu erfragen und für Dich nachvollziehbar machen zu lassen. Dadurch kannst Du Fehler schneller und leichter erkennen. ChatGPT z. B. kannst Du am Ende Deines Auftrags sagen: „Lege mir deinen Gedankengang dazu dar.“ Dieses Verfahren wird im Englischen als „Chain of Thought“-Prozess bezeichnet bzw. bei ChatGPT als „Thinking“-Modus und führt dazu, dass das Programm gründlicher arbeitet und Du in den einzelnen Arbeitsschritten sehen kannst, ob ein Fehler vorliegt. Leider ist in der kostenlosen Version von ChatGPT derzeit (August 2025) nur eine Anfrage im Thinking-Modus pro Tag möglich (OpenAI 2025).

Achtung – Fehlerquelle: Textzusammenfassungen

Besonders beim Zusammenfassen von Texten, einer scheinbar leichten Aufgabe, kommt es häufig zu Halluzinationen von KI-Programmen. Hier werden teilweise Informationen erfunden oder ergänzt und sogar mit Seitenangaben versehen, die im Originaltext gar nicht vorkommen.

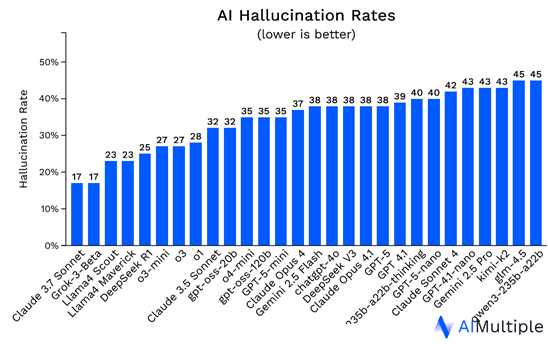

Dieses Phänomen erforschen auch Dilmegani und Daldal für AIMultiple Research. Die Grafik unten zeigt die Halluzinationsraten verschiedener LLMs bei der Beantowrtung von Prompts, in denen sich die Sprachmodelle explizit auf verschiedene CNN-Artikeltexte beziehen sollen. Tatsächlich halluzinieren einige der neueren Versionen von KI-Programmen bei diesen Aufgaben häufiger als ihre Vorgänger (Stand Juni, 2025; Dilmegani & Daldal 2025).

Daher gilt: Angaben aus KI-Zusammenfassungen immer mit dem Originaltext abgleichen!

Websuche integrieren

Bei ChatGPT 5.0 ist es möglich, eine Websuche zu integrieren. Das führt dazu, dass das Programm selbst schon überprüfen kann, ob es bestimmte Quellen gibt. Hierfür bietet sich zudem das KI-Programm „Perplexity“ an, das noch stärker auf die Suchfunktion ausgerichtet ist.

Aber bei allen Programmen gelingt die Vorauswahl oft nicht. Es kann auch hier falsche Ergebnisse und Halluzinationen geben.

Achtung – Fehlerquelle: Prompt

Wenn Du ChatGPT selbst fragst, wie Du zu möglichst glaubwürdigen Quellen kommst, wird es sagen, dass Du folgendes in den Prompt aufnehmen sollst: „Nur überprüfbare Quellen“ und „Mit direktem Link oder DOI“. Oft genug sind aber gerade diese angeblichen DOIs und URLS erfunden. Zudem rät es dazu, dass Du angibst, vorrangig institutionelle Quelle verwenden zu wollen (also solche mit Endungen wie .eu, oder .gov oder .edu).

Das ist nicht zu empfehlen, denn die wichtigste Quelle für wissenschaftliches Arbeiten sind wissenschaftliche Studien, deren Ergebnisse üblicherweise in begutachteten Fachzeitschriften erscheinen, nicht irgendwelche Institutionen.

Ausblick: KI-Nutzung für wissenschaftliches Arbeiten

ChatGPT, Mistral, Llama etc. sind – trotz neuer Funktionen – erst einmal weiter Sprachmodelle, die sich für manche Dinge (Strukturieren, Korrigieren) eignen, für andere nicht wirklich. KI-generierte Textzusammenfassungen können zwar einen ungefähren ersten Eindruck des Inhalts liefern, sind aufgrund möglicher Halluzinationen jedoch nicht zuverlässig und daher kein Ersatz für eigenes Lesen und Überprüfen von Fakten. Für die Suche nach wissenschaftlicher Literatur und konkreten Daten bieten sich andere Hilfsmittel eher an (z. B. Google Scholar, RUB Primo, Elicit u. a.). Dazu bloggen wir aber bestimmt auch noch einmal!

Quellen:

Dilmegani, C.: Daldal, A. 2025: AI Hallucination: Comparison of the Popular LLMs in 2025. https://research.aimultiple.com/ai-hallucination/ [14.7.2025]

Metz, C.; Weise, K. 2025: A.I. Is Getting More Powerful, but Its Hallucinations Are Getting Worse. In: New York Times, 5.5.2025 A.I. Hallucinations Are Getting Worse, Even as New Systems Become More Powerful – The New York Times [25.8.2025]

OpenAI 2025: GPT-5 in ChatGPT https://help.openai.com/en/articles/11909943-gpt-5-in-chatgpt [25.8.2025]

Siebert, J. (2024): Halluzinationen von generativer KI und großen Sprachmodellen (LLMs) https://www.iese.fraunhofer.de/blog/halluzinationen-generative-ki-llm/ [25.8.2025]

Vectara 2025: Hallucination Leaderboard https://github.com/vectara/hallucination-leaderboard [25.8.2025)